Sẽ rất khó tối ưu SEO onpage nếu bạn không biết rõ website mình đang thiếu gì, lỗi ở đâu. Đây chính là lúc Screaming Frog SEO Spider trở thành “cánh tay phải” của mọi SEOer. Với khả năng crawl toàn bộ website giống như Googlebot, công cụ này giúp phát hiện hàng loạt lỗi kỹ thuật, điều hướng, thẻ meta, duplicate content… – nhanh hơn nhiều lần so với việc kiểm tra thủ công từng trang.

Không chỉ là công cụ phân tích, Screaming Frog còn là nền tảng hỗ trợ audit toàn diện và lập kế hoạch SEO chính xác. Việc sử dụng nó đúng cách sẽ giúp tiết kiệm thời gian, tránh rủi ro và tăng hiệu quả tối ưu tổng thể.

Screaming Frog không chỉ thu thập URL bề mặt mà còn đi sâu vào toàn bộ cấu trúc nội dung, bao gồm cả JavaScript rendering, redirect chain, và cả những tệp robots.txt, sitemap. Đây là điều khiến nó vượt trội hơn nhiều công cụ SEO khác.

Từ lỗi 404, chuỗi chuyển hướng, đến thẻ meta thiếu hoặc trùng lặp – mọi vấn đề sẽ được liệt kê đầy đủ chỉ sau vài phút crawl. Nhờ đó, SEOer có thể xử lý ngay lập tức mà không bỏ sót bất kỳ chi tiết nào.

Bạn có thể xuất toàn bộ dữ liệu thành file Excel, CSV hoặc kết nối Screaming Frog với Google Analytics, Google Search Console để phân tích chuyên sâu hơn. Điều này cực kỳ hữu ích khi lập báo cáo SEO chuyên nghiệp cho khách hàng hoặc team marketing nội bộ.

Trước khi bắt đầu crawl website bằng Screaming Frog SEO Spider, có một số yếu tố quan trọng cần chuẩn bị để đảm bảo quá trình diễn ra mượt mà và cho kết quả chính xác nhất. Việc sẵn sàng về mặt phần mềm, kiến thức cơ bản và cấu hình phù hợp sẽ giúp bạn tiết kiệm đáng kể thời gian thao tác và tránh lỗi ngoài ý muốn.

Hãy truy cập trang chủ screamingfrog.co.uk để tải bản mới nhất. Có cả bản miễn phí (crawl tối đa 500 URL) và bản trả phí với tính năng đầy đủ hơn.

Trước khi chạy crawl, bạn cần biết mình muốn kiểm tra điều gì: cấu trúc URL, lỗi kỹ thuật, hay nội dung? Điều này sẽ giúp bạn thiết lập cấu hình crawl chính xác, tránh tốn thời gian xử lý dữ liệu không cần thiết.

Một số website giới hạn crawl hoặc có cấu hình chặn bot. Hãy kiểm tra file robots.txt và sử dụng tính năng User-Agent tùy chỉnh trong Screaming Frog để tránh bị chặn IP hoặc cấm truy cập dữ liệu quan trọng.

Biết cách đọc thẻ tiêu đề, mô tả meta, canonical, H1–H6… sẽ giúp bạn hiểu rõ báo cáo crawl hơn. Nếu chưa quen, nên tham khảo trước tài liệu SEO cơ bản hoặc xem video hướng dẫn sử dụng Screaming Frog trên YouTube.

Dù là người mới hay SEOer có kinh nghiệm, việc biết cách crawl website bằng Screaming Frog SEO Spider đúng quy trình sẽ giúp bạn khai thác tối đa sức mạnh của công cụ này. Từng bước dưới đây được thiết kế để đảm bảo dữ liệu bạn thu được là chính xác, đầy đủ và sẵn sàng cho phân tích chuyên sâu.

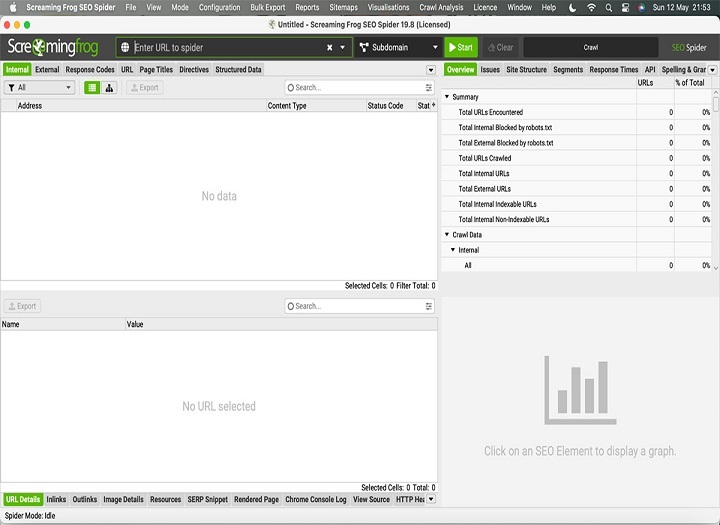

Sau khi cài đặt và mở phần mềm, bạn sẽ thấy ô nhập URL ngay ở giao diện chính. Nhập domain hoặc URL cụ thể bạn muốn crawl. Ví dụ: https://www.example.com. Nhấn Start để bắt đầu quá trình crawl.

→ Mục tiêu: Bắt đầu tiến trình thu thập dữ liệu từ website đích.

→ Mẹo: Đảm bảo URL có định dạng đầy đủ (https/http). Nếu chỉ muốn crawl một thư mục con, hãy cấu hình trong phần “Include”.

Trước khi nhấn Start, bạn nên vào mục Configuration > Spider để thiết lập thông số. Ví dụ:

→ Dấu hiệu đúng: Crawl nhanh, không thu thập dữ liệu rác.

→ Cảnh báo: Nếu không giới hạn crawl, bạn có thể làm đầy bộ nhớ tạm và khiến máy chậm đi đáng kể.

Khi crawl bắt đầu, bạn sẽ thấy dữ liệu liên tục được cập nhật theo dạng bảng. Các tab như Internal, External, Response Codes... sẽ hiển thị dữ liệu crawl theo từng tiêu chí.

→ Mục tiêu: Giám sát quá trình crawl và phát hiện URL lỗi sớm.

→ Lưu ý: Nếu thấy nhiều URL trả về 404 hoặc redirect loop, nên dừng crawl để kiểm tra cấu trúc site.

Khi crawl hoàn tất, bạn có thể lọc theo các tiêu chí như:

→ Công cụ hỗ trợ: Sử dụng thanh filter, advanced search, và export để xử lý nhanh.

→ Mẹo: Ưu tiên xử lý lỗi ảnh hưởng đến index (404, canonical sai).

Vào menu Export, chọn phần cần lưu (như Internal HTML, Meta Data...) rồi lưu dưới dạng Excel/CSV. Có thể import sang Google Sheets hoặc Data Studio để trực quan hóa.

→ Dấu hiệu hoàn tất: File báo cáo đầy đủ, dễ đọc, có thể dùng để audit hoặc gửi cho khách hàng.

Dù Screaming Frog là công cụ mạnh mẽ, nhưng việc sử dụng không đúng cách hoặc thiếu kinh nghiệm dễ dẫn đến các lỗi phổ biến làm sai lệch kết quả phân tích SEO. Dưới đây là những rủi ro thường gặp và cách khắc phục kèm theo cảnh báo kỹ thuật tương ứng.

Vấn đề phổ biến với bản miễn phí là giới hạn 500 URL. Khi crawl website lớn, dữ liệu sẽ bị cắt thiếu và phân tích không chính xác.

→ Cách khắc phục: Nâng cấp lên bản trả phí hoặc chia nhỏ crawl theo thư mục.

Một số website chặn bot bằng cấu hình robots.txt hoặc tường lửa. Screaming Frog khi đó sẽ trả về rất ít dữ liệu hoặc lỗi 403, 503.

→ Cách xử lý: Vào Configuration > Robots.txt và tắt tuân thủ nếu cần; dùng User-Agent tùy chỉnh như Googlebot.

Trang sử dụng nhiều nội dung tải qua JavaScript sẽ không hiển thị đủ nội dung nếu không bật JS rendering.

→ Cách bật: Vào Configuration > Spider > Rendering > JavaScript để crawl như trình duyệt.

→ Cảnh báo: Tốn nhiều RAM, nên dùng máy có cấu hình cao.

Crawl không xử lý tốt các chuỗi chuyển hướng hoặc thẻ canonical không đúng sẽ gây hiểu sai cấu trúc nội dung.

→ Mẹo kiểm tra: Vào tab Redirect Chains, Canonical Errors và lọc lỗi theo mã trạng thái HTTP.

Không phải cứ crawl xong là có ngay dữ liệu SEO chất lượng. Hiệu quả thực sự đến từ việc phân tích đúng, lọc đúng và biết cách đọc báo cáo. Dưới đây là những dấu hiệu cho thấy bạn đã sử dụng Screaming Frog SEO Spider đúng cách và gợi ý tối ưu nâng cao giúp kết quả crawl có giá trị hơn.

Dấu hiệu rõ ràng nhất là Screaming Frog crawl toàn bộ URL cần kiểm tra, không báo lỗi nặng như timeout, 403 hay 500. Nếu tab Response Codes chỉ ra phần lớn mã 200 (OK), bạn đã thành công bước đầu.

→ Gợi ý: Hãy lọc xem có bao nhiêu URL là indexable (có thể index), từ đó phân tích khả năng hiển thị của website.

Vào tab Page Titles, Meta Description và H1, kiểm tra tỷ lệ các trang:

→ Dấu hiệu tối ưu: Dưới 10% trang bị thiếu hoặc lỗi là tốt.

Khi bạn có thể xuất báo cáo và dùng nó để đề xuất chỉnh sửa thẻ tiêu đề, xây lại cấu trúc nội dung, xử lý redirect lỗi… thì crawl đó đã mang lại giá trị thực tế.

→ Gợi ý chuyên sâu: Kết hợp với Google Search Console để so sánh CTR của các trang bị lỗi meta title/description.

Sau khi sửa lỗi từ báo cáo trước, chạy lại Screaming Frog để đối chiếu thay đổi:

→ Dấu hiệu cải tiến tốt: Lỗi 404, redirect giảm mạnh và tăng tốc crawl.

Với thị trường SEO hiện nay, ngoài Screaming Frog SEO Spider, còn nhiều công cụ phân tích website như Ahrefs, SEMrush, Sitebulb, JetOctopus… Vậy có nên chọn Screaming Frog là công cụ chính? Dưới đây là phân tích giúp bạn đưa ra lựa chọn phù hợp theo nhu cầu thực tế.

→ Kết luận: Nếu bạn cần phân tích onpage kỹ thuật sâu, không gì vượt qua được Screaming Frog ở tầm giá hiện tại.

|

Công cụ |

Điểm mạnh chính |

Giới hạn |

|---|---|---|

|

Screaming Frog |

Phân tích kỹ thuật onpage |

Không có dữ liệu backlink, UI khó dùng |

|

Ahrefs |

Backlink, từ khóa, site audit đơn giản |

Crawl không sâu bằng Screaming Frog |

|

Sitebulb |

Báo cáo đẹp, trực quan |

Cần máy mạnh, không nhẹ như Screaming Frog |

|

SEMrush |

All-in-one SEO suite |

Crawl ít tùy chỉnh kỹ thuật sâu |

→ Gợi ý kết hợp: Dùng Screaming Frog để crawl sâu, và Ahrefs/SEMrush để theo dõi từ khóa và backlink sẽ tạo thành bộ đôi toàn diện.

Sử dụng Screaming Frog SEO Spider hiệu quả không chỉ dừng ở việc biết crawl website. Người dùng chuyên nghiệp còn tận dụng nhiều mẹo và tính năng nâng cao để rút ngắn thời gian xử lý, tối ưu quy trình làm việc và nâng cao độ chính xác trong phân tích SEO kỹ thuật.

Dưới đây là những kinh nghiệm thực chiến từ các SEO agency lớn giúp bạn nâng tầm kỹ năng sử dụng công cụ này.

Thay vì thiết lập lại cấu hình mỗi lần crawl, bạn có thể lưu profile cấu hình theo loại dự án:

→ Thao tác: File > Configuration > Save/Load Configuration.

Một tính năng mạnh nhưng ít người khai thác là Custom Extraction, cho phép bạn thu thập dữ liệu cụ thể từ trang web như schema, số điện thoại, cấu trúc giá sản phẩm…

→ Cách dùng: Configuration > Custom > Extraction > nhập regex hoặc XPath tương ứng.

→ Ứng dụng: Crawl hàng trăm landing page để kiểm tra có cài đủ schema không.

Khi liên kết Screaming Frog với GA & GSC, bạn có thể phân tích thêm các chỉ số thực tế như:

→ Kết nối: Configuration > API Access > chọn nguồn cần liên kết.

→ Lợi ích: Ưu tiên sửa lỗi ở những trang có khả năng tạo chuyển đổi cao.

Screaming Frog có sẵn tính năng vẽ sơ đồ cấu trúc URL, giúp nhận biết vấn đề về chiều sâu nội dung, internal linking và kiến trúc site.

→ Truy cập: Visualizations > Crawl Tree Graph hoặc Directory Tree Map.

→ Gợi ý: Nếu homepage quá ít liên kết nội bộ, nên cấu trúc lại navigation.

Bạn có thể đặt lịch crawl hàng tuần, hàng tháng để giám sát những thay đổi onpage. Điều này cực kỳ hữu ích với SEO lâu dài hoặc khi quản lý nhiều dự án.

→ Thiết lập: File > Scheduling (chỉ dùng được với bản trả phí).

→ Ứng dụng: So sánh dữ liệu tháng trước – tháng này để đánh giá hiệu quả tối ưu.

Khi sử dụng đúng cách, Screaming Frog SEO Spider giúp tiết kiệm thời gian, phát hiện lỗi kỹ thuật và hỗ trợ lập kế hoạch SEO chi tiết hơn. Qua từng bước hướng dẫn và mẹo nâng cao, bạn sẽ tối ưu quy trình crawl website và phân tích dữ liệu chuẩn xác. Hãy bắt đầu thử nghiệm với dự án của bạn và theo dõi kết quả cải thiện rõ rệt theo thời gian.

Có. Bản miễn phí cho phép crawl tối đa 500 URL/lần, phù hợp với website nhỏ hoặc nhu cầu học thử.

Có thể có nếu bạn crawl quá nhanh hoặc không giới hạn request. Nên điều chỉnh tốc độ crawl trong phần Configuration.

Có. Screaming Frog hỗ trợ cả Windows, MacOS và Ubuntu Linux.

Không. Công cụ chỉ phân tích onpage. Để phân tích backlink, nên dùng Ahrefs, Majestic hoặc SEMrush.

Bạn cần bật tính năng JavaScript Rendering trong Configuration > Spider > Rendering.

Tùy dự án, nhưng khuyến nghị nên crawl định kỳ mỗi tháng hoặc sau mỗi lần cập nhật nội dung lớn.